Elektroniktidningen har gjort en inventering av de färskaste nyheterna inom IP-kärnor och kretsar för acceleration av artificiell intelligens.

Elektroniktidningen har gjort en inventering av de färskaste nyheterna inom IP-kärnor och kretsar för acceleration av artificiell intelligens.

Du kan omöjligen ha missat hajpen kring artificiell intelligens. Du känner tillämpningarna – från ansiktsinloggning till självkörande bilar. Alla tror att de bara är de första dropparna i ett skyfall och att AI kommer att hitta tillämpningar överallt.

Den här texten har stuckit ner handen i nyhetsflödet efter sommaren och valt ut de nyheter som handlar om kretsar och kärnor. Inget om affärer, investeringar, politik, tillämpningar, utbildning och forskning. Inte ens om benchmarks, plattformar, och övrig hårdvara som moduler och kort. Utan enbart nyheter om dedikerade AI-kretsar och IP-kärnor för sådana kretsar.

Molnleverantörerna var först att stödja AI i hårdvara. Deras servrar har resurser för både programmering (träning) och användning (inferensdragning) av artificiella neuronnät. Den utvecklingen kommer även inbyggda system till godo i den utsträckning de kopplar upp sig mot molnet och delegerar AI-beräkningar dit.

Med Gooogles acceleratorkrets TPU som veterligen enda undantag använder dessa moln idag GPU:er, flerkärniga cpu:er och i viss utsträckning FPGA:er för AI-beräkningarna. Men flera dedikerade AI-kretsar kommer snart att göra TPU sällskap i serverhallarna. De har många namn, men här kallar vi dem enhetligt för NPU:er, neural processing units.

Vi kommer att få se NPU:er i alla sorts processorer. Nästa gång Elektroniktidningen gör en översikt av det här slaget, kommer IP-kärnorna vi berättar om här att finnas i generella styrkretsar, bland annat från NXP.

Den stora volymen av AI-beräkningar kommer därefter förmodligen att ske lokalt – IoT noder och wearables kommer att sköta dem själva istället för att skicka sina sensordata till molnet för analys.

Det kan faktiskt tänkas att lokala AI-beräkningar kanske redan dominerar, om man skulle räkna på det, på grund av telefonerna, eftersom de är så många, och de är flitiga användare av AI för röststyrning och text- och bildanalys. Fjärde kvartalet i år kommer 30 procent av alla nya telefoner att ha en systemkrets med en AI-kärna ombord.

Konkurrensen mellan AI-kärnor frodas nu när marknaden är färsk. Lite grand som approcessorer till mobiler kämpade mot varandra på 00-talet.

Det kommer säkert att ha skett en naturlig gallring till nästa gång vi inventerar utbudet. Men vilka som vinner går inte att säga idag. Utvecklingen av AI-algoritmer spretar så vilt att det redan enbart med hänvisning till detta är omöjligt att säga vilka arkitekturer och som blir vinnare på sikt.

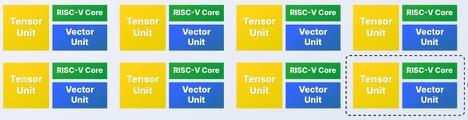

I grunden är en NPU ”pinsamt parallell” som det heter. Vill du dubblera prestanda i din neuronkärna? Ta två, och addera motsvarande mängd cache.

Men i praktiken kan minnesbandbredd och latens kan vara avgörande för både genomströmning och realtidsegenskaper. Där har fortfarande FPGA:er en styrkeposition. Tyvärr kommer de förmodligen att tappa den allteftersom kärnorna fryser till asicar.

FPGA:erna kommer att ha kvar sin totala flexibilitet vilket ger dem en chans att stanna i nischer som vill kunna skifta i realtid mellan olika neuronnät – de varierar dramatiskt i topologi och numerisk precision.

Prestandaangivelser för NPU:er är ett kaos eftersom beräkningarna görs i diverse olika numeriska format, såväl flyttal som heltal.

Det skapas till och med nya format. Google använder ett 16-bitars flyttal som flyttat några bitar från mantissa till exponent för att de gör mer nytta där. Fyrabitars heltal finns i kretsar idag, och det finns IP-kärnor som kan konfigureras till ända ner till en enda bits precision.

Vanligast är att prestanda anges i Tops, biljoner operationer per sekund. Du ser också angivelser i Mac – multiply-accumulate – som är operationen att addera produkten av två tal till en summa.

Är du nyfiken på hur den här marknaden utvecklas ska du följa Elektroniktidningens dagliga nyheter på etn.se.

De vill accelerera AI i datahallen |

|

I datacentraler för beräkningstunga tillämpningar, liksom i till exempel självkörande bilar, har de flesta hittills använt GPU:er för AI. Men både etablerade företag och uppstartsföretag knackar nu på dörren med skräddarsydda neuronnätsacceleratorer.

• NPU:n Ascend Max från Huawei ska tillverkas i 7 nm, dra 350 W och leverera 256 Tops i 16-bitars flyttal och 512 Tops i 8-bitars heltal. Den är den mäktigaste NPU:n i ett jämnt fördelat spann av sju varianter som Huawei ska ta fram. Den minsta heter Ascend Nano och levererar ynka 20 Mops och drar 1 mW. Alla är för företagets eget bruk och den första produkt som använder någon av dem släpps i februari. • Alibabas halvledarbolag Pingtouge utvecklar ett AI-chip kallat Ali NPU för bland annat moln och självkörande bilar.

• Sambanova arbetar på en processor men ger inga detaljer utöver att den bygger på ”banbrytande forskning” i mjukvara och hårdvara på Stanforduniversitetet.

|

De vill accelerera AI lokalt |

|

Till flera styrkretsar finns idag verktyg som låter dig enkelt ladda dem med neuronnät som snurrar i deras befintliga kärnor. I nästa eller nästnästa generation kommer du att få se dem med dedikerad AI-logik som skruvar upp deras prestanda och ner deras strömförbrukning. Här är några av de kretsar som är på väg, och några av de neuronkärnor som kommer att sitta i dem. • Synaptics har gjort tape-out i 22 nm FD-SOI hos Globalfoundries på en NPU för IoT. Prestanda ska ligga på i storleksordningen 1 Tops. Synaptics har ytterligare två kretsar på gång, specialiserade på röst och video respektive utökad och virtuell verklighet. Kärnorna är licenserade från okänd källa. • Den neuromorfa kretsen Akida från australiska Brainchip ska finnas tillverkad tredje kvartalet nästa år, dra under en watt, kosta tio dollar och vara betydligt effektivare än dagens AI-kärnor om man får tro Brainchip. Att den är neuromorf betyder att den i ännu högre utsträckning än en normal NPU låter tekniska detaljer i sin implementation inspireras av biologiska hjärnceller. • Nästa år släpper Renesas en NPU med 100 gånger högre AI-prestanda än en MPU. Efterföljaren år 2021 ska bli ytterligare tio gånger snabbare. • NPU:n Novutensor från Novumind ska kunna leverera 15 Tops på 5 W. Den finns i provexemplar i 28 nm. En 16 nm-version är under utveckling. • Nästa NPU-kärna från Arm Holdings ska leverera 4 Tops i en 1 GHz-krets och 3 Tops/W på ett 2,5 mm2-chip tillverkat i 7 nm. • Lattice släpper IP-block för FPGA:erna ECP5 och ICE40 Ultraplus. Du ska kunna bygga neuronkretsar som drar mellan 1 mW och 1 W och kostar mellan 1 och 10 dollar. • Cadence IP-kärna DNA 100 har fyra gånger fler Mac-enheter och tolv gånger högre prestanda än sin föregångare Vision C5. Den kan skalas upp till hundratals kärnor i en systemkrets för ungefär lika många tera-MAC/s. • Från Cambricon kan du – som Huawei redan gjort till sina telefoner – licensera kärnan 1M, som ska kunna leverera 5 Tops/W. Eller MLU100 som drar 80 watt och levererar 128 Tops i 8-bitars heltalsaritmetik. |

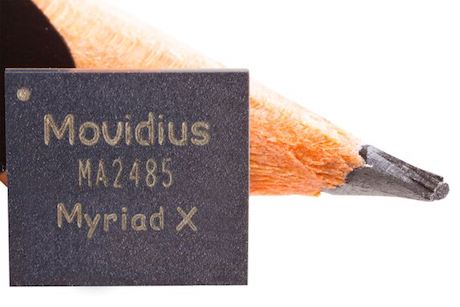

• Intel släpper acceleratorkort på både sin kretsfamilj Movidius och på Arria 10-FPGA:er. Intel har inte angett bestyckningarna i korten men en Movidius 2-NPU ger cirka 1 Tops och Movidius X ger tio gånger mer. Dell, Honeywell och QNAP är kunder.

• Intel släpper acceleratorkort på både sin kretsfamilj Movidius och på Arria 10-FPGA:er. Intel har inte angett bestyckningarna i korten men en Movidius 2-NPU ger cirka 1 Tops och Movidius X ger tio gånger mer. Dell, Honeywell och QNAP är kunder. • Neuronprocessorn TPU från Google uppgraderas snart till sin tredje generation med dubbla prestanda mot sin föregångare. Summa 350 Tflops levereras av en TPU när den använder 16-bitars flyttal med utökad exponent.

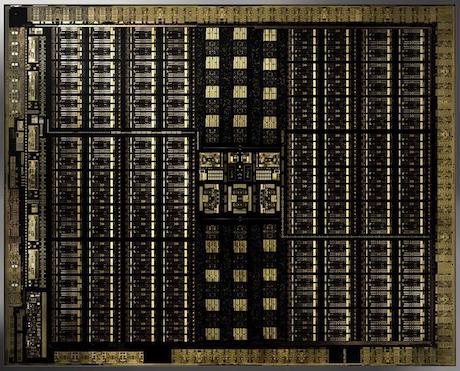

• Neuronprocessorn TPU från Google uppgraderas snart till sin tredje generation med dubbla prestanda mot sin föregångare. Summa 350 Tflops levereras av en TPU när den använder 16-bitars flyttal med utökad exponent. • Den neuronnätstrimmade grafikkretsfamiljen Turing från Nvidia släpptes i september i 12 nm med 18,6 miljarder transistorer i varianten TU102. En sådan best ger 430 respektive 215 Tops i fyra respektive åtta bitars heltal.

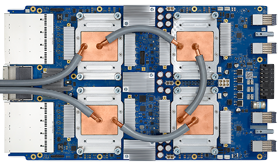

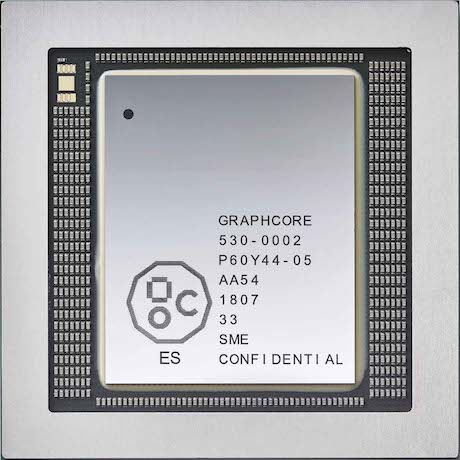

• Den neuronnätstrimmade grafikkretsfamiljen Turing från Nvidia släpptes i september i 12 nm med 18,6 miljarder transistorer i varianten TU102. En sådan best ger 430 respektive 215 Tops i fyra respektive åtta bitars heltal. • Graphcore ska tillverka sin NPU Colossus i 16 nm hos TSMC. Den ska släppas i år. Den har hela 300 Mbyte minne på chipet vilket betyder att den ska kunna träna ett stort neuronnät utan att behöva accessa externt RAM. Detta ska enligt vad Graphcore hoppas – företaget är faktiskt ärligt med att det bara är en förhoppning – ska ge chipet extrema prestanda under vissa omständigheter.

• Graphcore ska tillverka sin NPU Colossus i 16 nm hos TSMC. Den ska släppas i år. Den har hela 300 Mbyte minne på chipet vilket betyder att den ska kunna träna ett stort neuronnät utan att behöva accessa externt RAM. Detta ska enligt vad Graphcore hoppas – företaget är faktiskt ärligt med att det bara är en förhoppning – ska ge chipet extrema prestanda under vissa omständigheter. • Det finns provexemplar av en 16 nm-krets på 100 W för inferenser, kallad Goya HL-1000 från israeliska Habana. Ett chip för träning, Gaudi, ska finnas nästa år.

• Det finns provexemplar av en 16 nm-krets på 100 W för inferenser, kallad Goya HL-1000 från israeliska Habana. Ett chip för träning, Gaudi, ska finnas nästa år.